Auf der Zeitreise durch noch offene Tabs bin ich ueber die Folge „Innovationsmanagement“ aus dem Podcast „Innovationstheater“ von Dennis Horn gestolpert. Den Tab hatte ich auf Empfehlung von @saerdnaer seit Mai 2021 offen, und ich wuenschte, ich haette die Folge schon viel frueher anhoeren sollen, denn eigentlich steckt darin quasi alles, was ich schon ewig mal ueber „Experimentierraeume“ aufschreiben wollte 😀 Da die Episode aber nur spaerliche Shownotes hat, dachte ich, ich schlage einmal zwei Fliegen mit einer Klappe und fasse das etwas zusammen. Es gilt das gesprochene Wort 😉

Horn betrachtet in der Podcastserie vor allem, wie Medienhaeuser mal erfolgreich, mal hilflos mit diesem ganzen Digitalisierungs- und Innovationskram umgehen. In dieser besonderen Episode tauscht er sich mit Sascha Friesike zum Thema Innovation Labs aus – von denen zumindest in der Wirtschaft 9 von 10 mehr oder weniger bald wieder geschlossen werden.

Levke Wilkens hatte bei Friesike in ihrer Masterarbeit „Ungewissheit führen – Herausforderungen, Strategien und Anpassungen in ergebnisoffenen Projekten“ mittels Grounded Theory das Selbstverstaendnis solcher Labore theoretisch beschrieben, und Friesike schildert, dass dort staendig das Bild von Paradoxen aufgetaucht sei – man wolle quasi das grosse Auto, das aber in kleine Parkluecken passen solle.

In der Arbeit selber (leider ist sie derzeit nicht online oeffentlich verfuegbar) trennt Wilkens das Paradoxon vom Dilemma ab: Beim Dilemma stehen zwei Handlungsoptionen zur Wahl und man muss (und kann!) sich fuer eine entscheiden, nachdem man die Konsequenzen abgewogen hat. Dem Paradox dagegen wohnt ein unaufloeslicher Widerspruch inne – selbst wenn an einem Punkt eine Entscheidung getroffen wurde, passierte das jedoch schon auf einer hoeheren Ebene, die ausserhalb der Handlungsoptionen der Innovations-Labor-Aktiven lag. Man kommt bei den folgenden vier Paradoxen also vielleicht zur Erkenntnis, dass eine andere Handlung/Entscheidung sinnvoll (gewesen) waere – hat aber gar keinen Handlungsspielraum, das zu beeinflussen.

Innovationseinheiten sind zu oft mit sich selbst beschaeftigt (Paradox der entfremdeten Identitaet)

Paradox 1: Innovationseinheiten sind viel damit beschaeftigt, ueberhaupt herauszufinden, wer man eigentlich ist. Der Grund, warum man existiert, liegt ja darin begruendet, dass in der Mutterorganisation etwas nicht funktioniert – weil sonst haette man ja nicht gegruendet werden muessen. Gleichzeitig ist man Teil der Mutterorganisation und muss ihr daher ja irgendwie verbunden sein.

Die Reflexion, was man eigentlich sei und tun soll, nimmt dabei viel Zeit der Entwicklung ein. Selbst die dort Eingesetzten kommen haeufig mit einer anderen Vorstellung an, was sie eigentlich tun (sollen) als dem, was sie dann tatsaechlich tun. Eine grosse Frage ist vor allem, wie man denn die geschaffenen Erkenntnisse wieder ins Mutterschiff ueberfuehren soll.

Verbunden damit ist die staendige Suche nach „verrueckten Ideen“. Die Einheit denkt sich also etwas aus, das wird dann dem Management vorgestellt, und das zuckt mit den Schultern, weiss nicht so recht was damit anzufangen und fragt nach der naechsten verrueckten Idee. Langfristig wird also irgendwann die Frage aufkommen: Wozu die verrueckten Ideen finden, wenn das Feedback ist, dass so etwas in der Muttereinheit ja gar nicht funktionieren koenne?

Die Metapher vom Schnellboot und dem Tanker

Hier geht es um die (ueber)bemuehten Metaphern wie z.B. der Innovationseinheit als Schnellboot und dem Mutterschiff als traegem Tanker. Nur: Wie soll eigentlich ein Schnellboot einen Tanker manoevrieren? Das Schnellboot kann schnell wegfahren, aber wie soll aus der Umgebungserkundung des Schnellboots eine wirksame Kurskorrektur folgen? In der Metaphernlogik braucht es dann einfach weitere Einheiten, die „Schlepper“ oder „Leuchttuerme“ sind. Offen bleibt aber die Kernfrage der Wirkung: Woher kommt die Kurskorrektur beim Kommando auf der Bruecke des Tankers?

In der Masterarbeit wird dies das „Paradox der kontrollierten Flexibilitaet“ genannt: Die neue Einheit soll jetzt Loesungen erarbeiten, die vom Mutterschiff angenommen werden. Der Prozess, wie das dann passiert, ist aber nur selten vorausgedacht. Meist handelt es sich bei den betroffenen Organisationen um solche mit stark durchformalisierten Prozessen und starken Pfadabhaengigkeiten, die nun wahrgenommen haben, dass da draussen in der Digitalisierung viel schnellere Aenderungsprozesse erforderlich werden. Hierfuer wird also eine neue Unterorganisation geschaffen, die das mal erledigen soll.

In der Folge fallen zwei Arbeitsfelder auf: Zum Einen kann es um konkrete Produktentwicklung gehen – beispielsweise bei einem klassischen Automobilhersteller, der nun feststellt, dass man sich vielleicht um Elektromobilitaet kuemmern sollte. Die Einheit arbeitet also an konkreten Produkten, die sich diesem Problem stellen. Zum Anderen waere aber fuer den Vollzug in der Linie eigentlich breit angelegte Organisationsentwicklung notwendig. Letzteres ist aber meistens gar nicht im Scope der Einheit, die sich dadurch sofort wieder in der Identitaetskrise befindet und/oder gar keine Mechanismen vorfindet, auf die Organisationsentwicklung der klassischen Struktur Einfluss nehme zu koennen.

Unabhaengigkeit ist wichtig, dadurch geht aber die Wirksamkeit verloren

Das Paradox der wirksamen Distanz: Einerseits muesste die Innovationseinheit weit genug von der starren Struktur der Muttereinheit entfernt sein, um auch tatsaechlich Dinge umsetzen zu koennen. Sobald sie aber hierfuer weit genug vom Mutterschiff entfernt ist, ist sie aufgrund der Durchformalisierung gleichzeitig gar nicht mehr in der Lage, die geschaffenen Innovationen und Erkenntnisse in die Linie zurueck zu integrieren. Folglicherweise bedarf es einer mindestens genau so grossen Gruppe von LobbyistInnen, die die Formalismen und Ablaeufe des Mutterschiffs verstehen, um die Erkenntnisse zu uebersetzen und fuer die urspruengliche Organisation auch verdaulich und anschlussfaehig machen. Denn die „InnovatorInnen“, die man fuer den eigentlichen Erkenntnisgewinn oder die Schaffung neuer Dinge herangezogen hat, haben auf solche Arbeit – verstaendlicherweise – ueberhaupt keinen Bock.

Innovationseinheiten haben einen Auftraggeber, der die Umsetzung gleichzeitig verhindert

Letztlich bleibt das Paradox der folgenlose Mission: Gleichzeitig soll radikale Innovation geschaffen werden, der Auftraggeber wird aber am Ende sagen, dass diese Forderungen viel zu radikal sind und in der Organisation gar nicht oder nur mit einem sehr sehr langen zeitlichen Horizont umsetzbar ist. Im Podcast ist hier von Firmen oder Medienkonzernen die Rede, dieselbe Argumentation duerfte aber auch verwaltungsnahen Menschen bekannt sein: Die Pfadabhaengigkeiten der Kultur und Hierarchie sind so stark, dass die vorgeschlagenen Wege an Aussagen wie „das haben wir aber schon immer so gemacht“ oder „[Einheit] ist aber so, das laesst sich nicht aendern, das muss man hinnehmen“ ausgebremst werden. Es fehlt also an der Verankerung in den Machtstrukturen, den Impulsen auch eine konkrete Umsetzung folgen zu lassen.

Friesike erzaehlt hier eine Anekdote, ueber die ich laut lachen musste: Eine Innovationseinheit habe von Anfang an viele Leute aus der etablierten Struktur fuer Lobbyarbeit eingestellt, um die Ideen in diese Struktur zurueckzutragen. Das Resultat war, dass gerade aus dieser Lobbygruppe enorm viele Angestellte die Einheit verlassen haben – und zwar nicht wieder zurueck in die Hauptorganisation, sondern ganz raus aus dem Konzern, in spannendere andere Anstellungen. Sie hatten in der Innovationseinheit gelernt und vorgelebt bekommen, was eigentlich alles moeglich waere, wenn nur die Arbeitskultur und die notwendige Infrastruktur vorhanden waere. Und als Resultat hatten sie Lust daran gewonnen, das mit der Situation im Mutterkonzern verglichen, und ihre Konsequenzen daraus gezogen. Hier wuerde ich mir einmal eine Analyse solcher Mechanismen im Verwaltungskontext interessieren.

Keine Wirksamkeit? Flucht in Preise!

Das Grinsen liess bei der folgenden Frage nicht nach: Was tun, wenn man feststellt, dass man mit seiner Arbeit keine Wirksamkeit in der (angeblich) zu aendernden Mutterorganisation erfaehrt? Runter vom Schnellboot? Friesike entgegnet trocken, dass man in der Medienlandschaft wohl die Flucht in Preise antrete, und z.B. nach einem Grimme-Award schiele. Wenn die Anerkennung schon nicht aus Wirksamkeit oder erfuellender Arbeit in einem spanennden Team komme, schaffe man eben abgrenzbare Produkte, fuer die es einen Preis gibt. Auch hier sind Parallelen zur Verwaltungs-Digitalisierungswelt schnell gefunden.

Ich kann die Folge nur waermstens allen empfehlen, die in dem Feld unterwegs sind. Einige Highlights des dritten Drittels, sinngemaess zitiert:

- Wenn man irgendwo hingeht und dort ein Schnitzel isst und das ist nicht gut – das kann mal passieren. Aber wenn man Jahre spaeter wieder hingeht und das Schnitzel ist immer noch nicht gut, muss man die Frage stellen, was die in der Zwischenzeit (nicht) gelernt haben und warum

- Es scheint teilweise der Wille zu fehlen, herauszufinden, was muss man eigentlich verbessern. Das ist eine Aufgabe fuer die Organisation selber, sich zu verbessern.

- Innovation auslagern heisst auch, dem Rest zu sagen: das ist gar nicht eure Aufgabe. Dafuer haben wir ein Team gebaut. Wird dann das Team gestrichen, ist auch das Thema abgeschafft.

- Wenn es eine Loesung gaebe, haetten wir das Problem nicht. Das haengt immer an der Organisation, ihren Parametern etc. Das ist ein Prozess, den die Organisation selbst durchlaufen muss, und die Innovationsorganisation unterstuetzt bei diesem Wandel nur. Nur ist der Disconnect meist viel zu gross.

- Eigentlich muesste sich die Organisation ueber die Zeit hinweg entwickeln, sich diese Themen selber aufzuschaffen und sie selber zu uebernehmen.

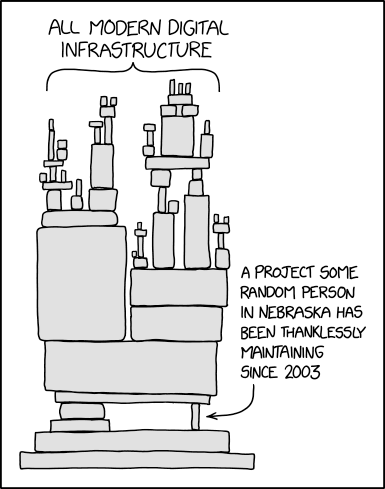

- Zudem das Problem der Innovation delusion: Es geht immer nur um das „Neue“, aber nicht um das Reparieren bestehender Dinge, vor allem der Infrastruktur. Dinge sind einfach da, fallen nicht auf, bis sie kaputt sind, aber das ist nichts, womit man Preise gewinnt.

- Den Beteiligten von Innovationslaboren werde haeufig Arroganz vorgeworfen. Die liegt vielleicht schlicht im Uebermut der Akteure begruendet, die glauben, dass sie das alles jetzt mit [hier Methode einfuellen] geloest bekommen. Im Gegenmodell: Wenn deine Innovationsleute wirklich realistisch einschaetzen koennten, wie hoch eigentlich die Chancen sind, wirklich etwas zu veraendern, wuerden sie sich den Schuh gar nicht anziehen.

- Womit man bei einem der Grundprobleme waere: Man stellt Leute an, gibt ihnen die Erwartung, wirklich etwas aendern zu koennen, und dann werden sie frustriert.

- Und zum Schluss die Gretchenfrage: Ist die Erwartung denn wirklich, dass im Innovationslabor wirklich Aenderung geschieht? Oder dient das vielmehr als Ort zum stolz vorzeigen, als Utensil mit dem man vorweisen kann, etwas zu tun?