„Kommunalverwaltungen sind keine IT-Entwickler“, titelte Sven Hense aus Bonn dieser Tage. Ich war zuerst reflexartig gewillt, ihm zu widersprechen: Ich hatte hier mehrfach gefordert, dass Verwaltungen genau solche Faehigkeiten internalisieren sollen, die man fuer Softwareentwicklung braucht. Und das dann auch anwenden zu koennen:

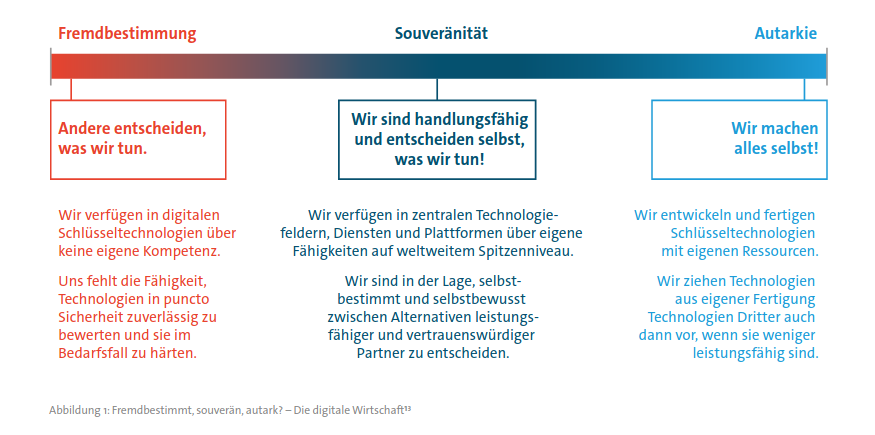

wenn dieses Digitalisierungszeug endlich mal gelingen soll […] gehoert […] auch passende Kompetenz in der Verwaltung aufgebaut. Muessen zumindest manche VerwaltungsbeamtInnen auch irgendwann mal Cronjobs und Shellscripts einrichten koennen. Muessen dafuer schnell passende VMs fuer die Verwaltung klickbar sein. Muss statt Innovationstheater mit (natuerlich nicht transferierbaren) Leuchttuermen die marode IT-Basisinfrastruktur in einen brauchbaren Zustand versetzt und kontinuierlich weiter gewartet werden koennen. Nicht unbedingt, weil die oeffentliche Hand alles selber machen koennen sollte. Im Gegenteil, moeglichst viel sollte als Commodity klickbar sein. Dafuer muesste man aber wissen, was es alles gibt, und Technikfolgen abschaetzen koennen. Und dafuer hilft es ungemein, mal ellenbogentief in APIs gewuehlt zu haben.

Ich glaube, dass meine Forderung immer noch gilt, und dass Sven Recht hat. Denn er beschreibt ein Modell, das in den letzten Jahren immer beliebter geworden ist: Die Kommunen sollen’s richten, indem sie selber die Loesungen stricken, die es braucht, aber um die sich niemand kuemmert. Also eben nicht nach dem Showing-whats-possible-doing-whats-necessary-Muster, bei dem man zeigt was moeglich waere, als Anlass der zustaendigen Stellen, endlich das zu tun, was es dafuer braucht. Sondern, indem sich Bund und Laender aus der Verantwortung stehlen und die Kommunen tragen die Last – in einem „Wettbewerb der Ideen“, der dazu noch perverse Anreize fuer ziellose Digitalisierungsperformance schafft.

Anstatt die marode IT-Basisinfrastruktur zu staerken, laeuft die Foerderschiene naemlich etwa so: Bund und/oder Laender suchen sich ein aktuelles Hypethema aus, um das man nicht herumkommt. Dafuer ist natuerlich eine „Strategie“ aufzustellen. Leider weiss man selber auch nicht so richtig, was man damit anfangen soll. Also werden Foerdermittel ausgelobt, auf die sich Regionen oder Kommunen doch bewerben moegen, und wenn alles gut geht, wird irgendeine der Foerdernehmerinnen schon etwas abliefern, was man am Ende stolz vorzeigen kann. Man hat was getan, muss sich selber nicht kuemmern, und die auserkorenen Regionen/Kommunen duerfen stolz wie Bolle sein, wie sehr man ihnen zutraut, die Zukunft der Digitalisierung mit passgenauen Leuchttuermen zum neuesten Hype auszuleuchten. Aller Seiten Egos sind gestreichelt, und jetzt muss man nur noch irgendwas entwickeln.

Bloederweise geht es dabei selten um die beklagte marode IT-Basis, die man eigentlich zappelnd und schreiend ins 21. Jahrhundert modernisieren sollte. Mit einer gewissen Weitsicht koennte man die derweil einfach im Vorbeigehen mit Teilen dieser Foerdersumme begiessen, so dass das Geld nicht ganz zum Fenster hinausgeworfen ist. Stattdessen ist meist das Gegenteil der Fall: Die gewuenschten Modellprojekte – egal ob jetzt Digitaler Zwilling, Datenraeume, Datenplattformen oder eine sonstige Mode damit abgefruehstueckt werden soll – muessen gelingen, egal was eine kritisch-unabhaengige Begutachtung ergibt. Damit dieser Eindruck aufrechterhalten werden kann, muessen irgendwelche Datenfluesse, Systeme, sonst etwas an die bestehende Legacy-IT angedengelt werden. Technische Schulden werden damit also nicht abgebaut, sondern weitere Interimsbaracken an das aechzende Gesamthaus genagelt, die irgendwann irgendein armes Team wieder abraeumen muss. Wie es mit Wartung und Unterhalt dieser Systeme aussehen soll, ist ebenfalls unklar. Ich wuerde mittlerweile sagen, dass das in gar nicht so wenigen Faellen unter dem Strich ein Draufzahlgeschaeft wird, weil die langfristigen Folgekosten die kurzzeitige Foerderung uebersteigen werden.

Leider fehlt dafuer aber viel zu haeufig ein verwaltungsinterner Blick auf die systemischen Zusammenhaenge der IT-Landschaft und wohin sie sich entwickeln sollte. Und das liegt nicht einmal daran, dass viele der in den Foerderaufrufen gewuenschten Projekte bei den Kommunen eventuell einfach am falschen Ort sind. Bei den meisten Innovation-durch-Wollen-Projekten, denen ich begegnet bin, haette man mit einem Verstaendnis dafuer, wohin man eigentlich will, gar nicht so wenig bewegen koennen. Dafuer haette es aber der Bereitschaft bedurft, nicht nur Sachmittel fuer externe Beratung und Dienstleistung auszugeben, sondern auch Kompetenz im Stellenplan zu verankern und das auch langfristig weitertragen zu wollen. Die fuer diese Entscheidung zustaendigen Gremien verfuegen aber derzeit meist selbst nicht ueber ein Gefuehl fuer IT-Strategie und Opportunitaetskosten (siehe Biancas aktuelle Kolumne), und so dreht sich das Rad weiter. Und nicht zuletzt scheint es bisweilen auch einfach egal, ob das gewuenschte Produkt architekturell ueberhaupt Sinn und Nutzen ergibt – es ging eigentlich nur um einen Dunkelleuchtturm, der Energie und Aufmerksamkeit aufsaugt und allein dem Status und Ansehen dient.

tl;dr: Es ist ultra hilfreich, Kompetenzen zu internalisieren, die man fuer Entwicklung/Betrieb/Deployment von Software braucht. Allein, um aus diesem Wissen die strategischen Pfade auszuwaehlen, die langfristig den Abbau technischer Schulden ermoeglichen oder zumindest den effizientesten Einsatz von Mitteln bedeuten. Stattdessen lagern Bund und Laender derzeit abstrakte Wunschvorstellungen ueber Giesskannenfoerderung an Kommunen aus, die viel zu oft gar nicht die richtigen Anforderungen skizzieren koennen und politisch gewollte Produkte bauen, die womoeglich sowieso niemandem etwas nuetzen.